Материалы по тегу: pensando systems

|

12.11.2025 [23:23], Владимир Мироненко

От ИИ ЦОД до роботов: AMD анонсировала долгосрочную стратегию роста

amd

cpu

dpu

epyc

hardware

instinct

mi400

mi500

ocp

pensando systems

ualink

ultra ethernet

venice

verano

xilinx

ии

ускоритель

финансы

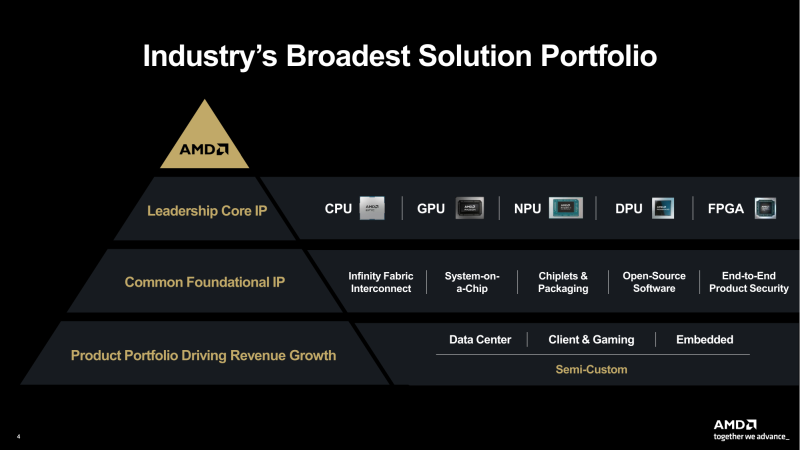

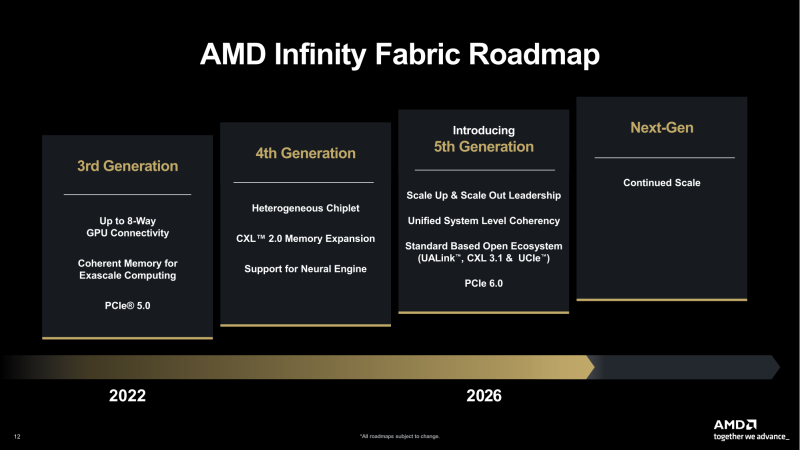

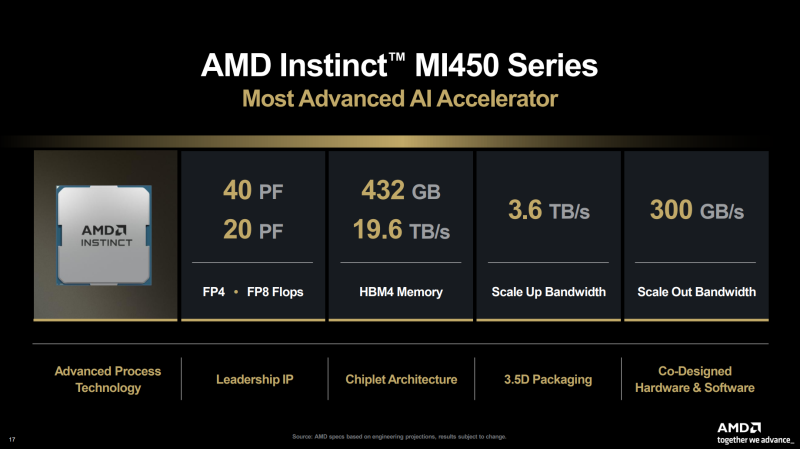

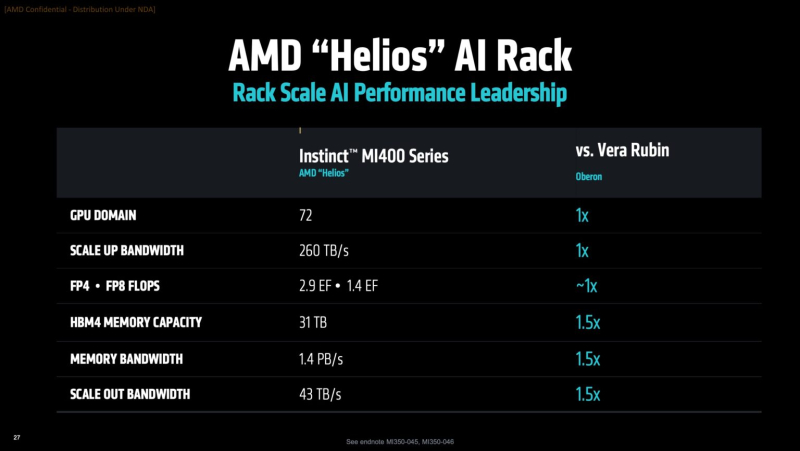

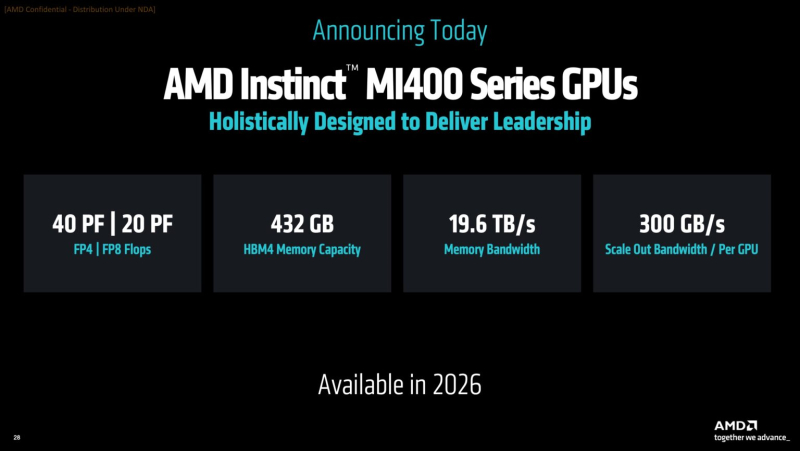

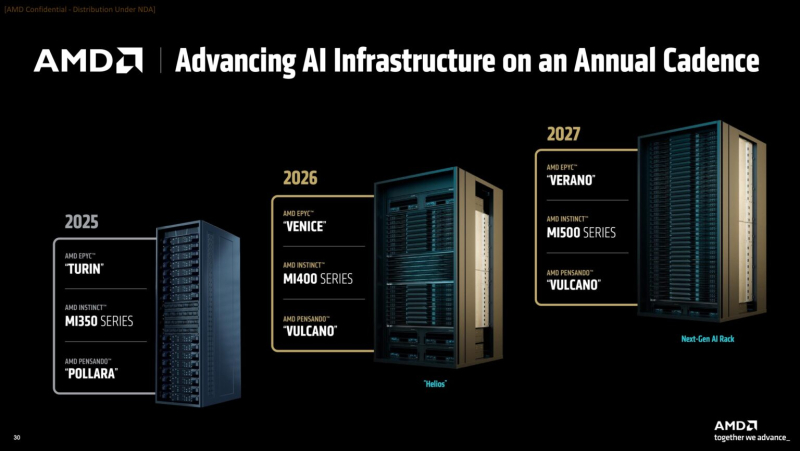

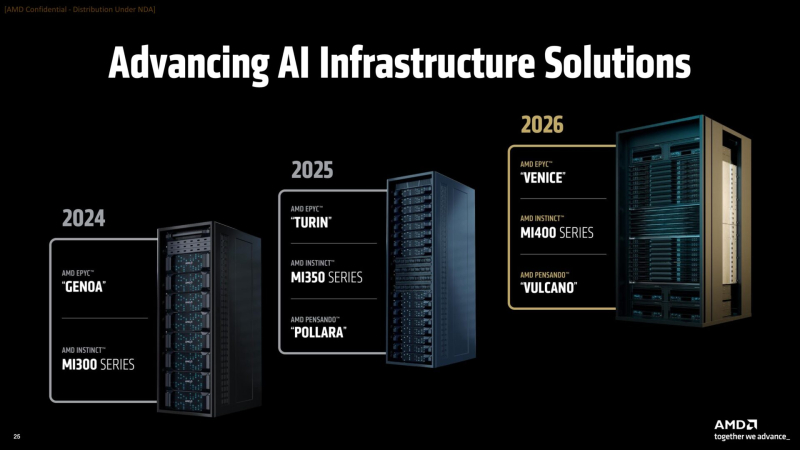

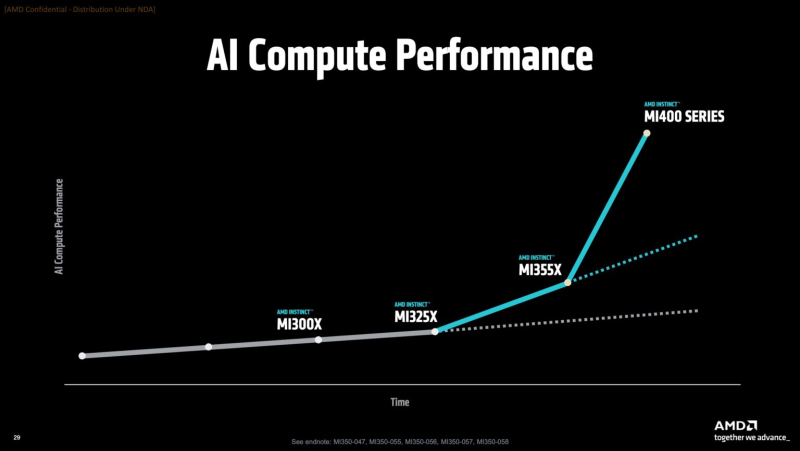

AMD представила на мероприятии Financial Analyst Day 2025 план по достижению лидерства на рынке вычислительных технологий объёмом $1 трлн. Долгосрочная стратегия роста AMD построена на четырех столпах: лидерство в сфере ЦОД, повышение производительности ИИ, открытое ПО и расширение присутствия на рынках встраиваемых и полукастомных кремниевых решений. AMD ожидает, что только её бизнес в сфере ЦОД будет приносить более $100 млрд годовой выручки, с увеличением совокупного среднегодового темпа роста (CAGR) до более чем 60 %, при этом CAGR дохода от ИИ-решений увеличится до более чем 80 %. Генеральный директор AMD Лиза Су (Lisa Su) заявила, что следующий этап будет основан на унифицированной вычислительной платформе AMD, объединяющей процессоры EPYC, ускорители Instinct, сетевые решения Pensando и ПО ROCm. Новый план развития AMD призван обеспечить ей конкуренцию с NVIDIA и Intel на корпоративных рынках и в борьбе за заказы гиперскейлеров. Ускорители серии Instinct MI350, уже развёрнутые Oracle (ещё 50 тыс. MI450 будут развёрнуты во II половине 2026 г.), являются самыми популярными ускорителями AMD на сегодняшний день. Следующей платформой станет серия MI450, которая будет запущена вместе со стоечной платформой Helios в III квартале 2026 года. Helios обеспечит пропускную способность интерконнекта 3,6 Тбайт/с на каждый ускоритель и до 72 ускорителей на стойку с совокупной пропускной способностью 260 Тбайт/с, соединённых между собой посредством UALink и Ultra Ethernet (UEC). Система поддерживает разделяемую память между ускорителями, что обеспечивает обучение крупномасштабных моделей с бесперебойным доступом к памяти и отказоустойчивой сетью с шестью плоскостями. AMD характеризует Helios как свою первую ИИ-платформу стоечного масштаба — полностью интегрированную систему с открытой архитектурой, которая объединяет вычислительные мощности, ускорение, сетевые технологии и ПО в единую структуру. В отличие от традиционных серверных кластеров, Helios реализует всю стойку как единый высокопроизводительный вычислительный домен. Каждая стойка объединяет процессоры AMD EPYC Venice, CDNA5-ускорители Instinct MI450X (будет и вариант MI430X с полноценными FP64-блоками) и 400G/800G-карты Pensando Vulcano, связанные Infinity Fabric пятого поколения (PCIe 6.0, CXL 3.1, UCIe) и UALink. Эта архитектура минимизирует накладные расходы на перемещение данных, увеличивает пропускную способность между ускорителями и обеспечивает эффективность класса экзафлопсных вычислений в компактном корпусе. Helios фактически представляет собой проект AMD для ИИ-фабрики будущего с возможностью модульного расширения, позволяя объединять сотни стоек в одну систему в ЦОД. В 2027 году AMD планирует выпустить ускорители серии MI500 и процессоры EPYC Verano, продолжая тем самым ежегодный цикл совместной разработки процессоров, ускорителей и сетей. AMD заявила, что EPYC Venice, намеченные к выпуску в 2026 году, будут обладать лучшими в отрасли показателями плотности (1,3x по количеству потоков в сравнении с текущими решениями) и энергоэффективности (1,7x). Они пополнятся оптимизированными для ИИ наборами инструкций для обработки инференса и выполнения вычислений общего назначения. Указанные компоненты станут основой ИИ-фабрики, способной масштабироваться от одной стойки до глобально распределённых кластеров. Исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) подчеркнул в своём выступлении, что производительность ИИ всё больше зависит от сети. Сетевые карты AMD Pensando Pollara и Vulcano для ИИ образуют связующую ткань архитектуры Helios. Сетевая карта Pollara 400 обеспечивает пропускную способность 400 Гбит/с, а готовящаяся к выходу сетевая карта Vulcano удвоит её до 800 Гбит/с, обеспечивая связь Ultra Ethernet между крупными кластерами ускорителей. AMD представила четырёхуровневую архитектуру сети для масштабных ИИ-инфраструктур. Front-End часть обслуживает пользователей, хранилище и приложения. Она опирается на DPU Pensando и P4-движки, отвечающие за разгрузку сетевых функций, функции безопасности и шифрования, и работу с СХД. Вертикальное масштабирование в пределах стойки обеспечивает 3,6-Тбайт/с подключение на каждый GPU. Горизонтальное масштабирование реализуется благодаря UEC — внутренние тесты показали снижение затрат на коммутацию до 58 % по сравнению с традиционными сетями типа Fat-Tree. Наконец, Scale-Across (пространственное масштабирование) позволит объединить географически распределённые ЦОД в кластеры с интеллектуальным управлением трафиком и адаптивной балансировкой нагрузки. AMD отметила, что открытый программный стек ROCm (Radeon open compute) по-прежнему лежит в основе её стратегии в области ИИ-платформ. По сравнению с прошлым годом число его загрузок выросло в десять раз и теперь на HuggingFace поддерживается более 2 млн моделей. ROCm интегрируется с ведущими фреймворками, включая PyTorch, TensorFlow, JAX, Triton, vLLM, ComfyUI и Ollama, и поддерживает проекты с открытым исходным кодом, такие как Unsloth. AMD также расширила своё видение «физического ИИ», когда вычисления выходят за рамки облака и охватывают роботов, транспортные средства и промышленные системы. Подразделение встраиваемых систем, усиленное приобретением Xilinx в 2022 году, превратилось из бизнеса, ориентированного на FPGA, в многоплатформенный двигатель роста, охватывающий адаптивные системы на кристалле (SoC), встраиваемые x86-процессоры и заказные кремниевые решения. По словам компании, с 2022 года решения в этой области принесли более $50 млрд. AMD рассчитывает превысить 70 % доли рынка адаптивных вычислений. Говоря о перспективах, компания отметила, что ЦОД остаются основным драйвером роста, но наряду с этим она будет диверсифицировать свою деятельность по всем сегментам. Финансовые цели AMD включают:

15.10.2025 [12:14], Владимир Мироненко

Oracle запустит в 2026 году ИИ-кластер на базе 50 тыс. AMD Instinct MI450Oracle объявила о расширении сотрудничества с AMD, в рамках которого Oracle Cloud Infrastructure (OCI) запустит первый публично доступный ИИ-суперкластер на базе 50 тыс. ускорителей AMD Instinct MI450. Согласно пресс-релизу, первоначальное развёртывание кластера начнётся в III квартале 2026 года, после чего он будет расширяться в 2027 году, а также в дальнейшем. Будущие ИИ-кластеры OCI будут основаны на стоечной архитектуре AMD Helios с использованием ускорителей AMD Instinct серии MI450, процессоров AMD EPYC следующего поколения с кодовым названием Venice и сетевой системы AMD Pensando следующего поколения с кодовым названием Vulcano. Махеш Тиагараджан (Mahesh Thiagarajan), исполнительный вице-президент OCI отметил, что благодаря десятилетнему сотрудничеству с AMD — от ускорителей EPYC до AMD Instinct — компания продолжает предоставлять «оптимальную по соотношению цены и производительности, открытую, безопасную и масштабируемую облачную платформу в партнерстве с AMD, чтобы удовлетворить потребности клиентов в новой эре ИИ». Ускоритель AMD Instinct MI450 основан на архитектуре CDNA 5 и изготавливается по 2-нм техпроцессу TSMC. Ускоритель будет обладать до 432 Гбайт памяти HBM4 с пропускной способностью 20 Тбайт/с. Стойка AMD Helios с 72 ускорителями AMD Instinct MI450 объединяет возможности масштабирования UALoE и масштабируемую сеть на базе Ethernet, соответствующую стандартам Ultra Ethernet (UEC), для минимизации задержек и максимальной пропускной способности между модулями и стойками.

Источник изображения: Oracle Сообщается, что процессоры EPYC (Venice) будут предлагать возможности конфиденциальных вычислений и встроенные функции безопасности для комплексной защиты конфиденциальных рабочих ИИ-нагрузок. Конвергентные сети с DPU, созданные на основе полностью программируемой технологии AMD Pensando, обеспечат безопасность и производительность, необходимые ЦОД для работы с ИИ следующего поколения, включая обучение, инференс и облачные рабочие нагрузки. Каждый ускоритель может быть оснащён до трёх DPU Vulcano со скоростью передачи данных 800 Гбит/с. Несколько месяцев назад Oracle и AMD объявили, что провайдер облачных вычислений развернёт кластер, включающий до 131 072 ускорителей AMD MI355X, на основе ранее запущенного кластера на базе AMD Instinct MI300X. Ранее в этом месяце стало известно о соглашении AMD с OpenAI на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт на сумму около $60–$80 млрд для обеспечения её ИИ-инфраструктуры.

13.06.2025 [02:20], Владимир Мироненко

AMD готовит ИИ-стойки Helios AI двойной ширины с Instinct MI400, AMD EPYC Venice и 800GbE DPU Pensando VulcanoВместе с анонсом ускорителей MI350X и MI355X также рассказала о планах на ближайшее будущее, включая выпуск ускорителей серий MI400 (Altair) в 2026 году и MI500 (Altair+) в 2027 году, а также решений UALink, Ultra Ethernet, DPU Pensando и стоечных архитектур, которые послужат основой ИИ-кластеров. Так, AMD анонсировала новую архитектуру Helios AI с стойками двойной ширины, которая объединит процессоры AMD EPYC Venice с ядрами Zen 6, ускорители Instinct MI400 и DPU Vulcano. Благодаря приобретению ZT Systems компания смогла существенно ускорить разработку и интеграцию решений уровня стойки — Helios AI появятся уже в 2026 году. Как сообщает DataCenter Dynamics, Эндрю Дикманн (Andrew Dieckmann), корпоративный вице-президент и генеральный менеджер AMD по ЦОД рассказал перед мероприятием, что решение об увеличении ширины стойки было принято в сотрудничестве с «ключевыми партнёрами» AMD, поскольку предложение должно соответствовать «правильной точке проектирования между сложностью, надёжностью и предоставлением преимуществ производительности». По словам AMD, это позволит объединить тысячи чипов таким образом, чтобы их можно было использовать как единую систему «стоечного масштаба». «Впервые мы спроектировали каждую часть стойки как единую систему», — заявила генеральный директор AMD Лиза Су (Lisa Su) на мероприятии, пишет CNBC. Дикманн заявил, что Helios предложит на 50 % больше пропускной способности памяти и на 50 % больше горизонтальной пропускной способности (по сравнению с NVIDIA Vera Rubin), поэтому «компромисс [за счёт увеличения ширины стойки] был признан приемлемым, поскольку крупные ЦОД, как правило, ограничены не квадратными метрами, а мегаваттами». Как указано в блоге компании, «Helios создана для обеспечения вычислительной плотности, пропускной способности памяти, производительности и горизонтального масштабирования, необходимых для самых требовательных рабочих ИИ-нагрузок, в готовом к развёртыванию решении, которое ускоряет время выхода на рынок». Helios представляет собой сочетание технологий AMD следующего поколения, включая:

AMD отказалась сообщить стоимость анонсированных чипов, но, по словам Дикманна, ИИ-ускорители компании будут дешевле и в эксплуатации, и в приобретении в сравнении с чипами NVIDIA. «В целом, есть существенная разница в стоимости приобретения, которую мы затем накладываем на наше конкурентное преимущество в производительности, поэтому выходит значительная, исчисляемая двузначными процентами экономия», — сказал он. AMD ожидает, что общий рынок ИИ-чипов превысит к 2028 году $500 млрд. Компания не указала, на какую долю общего пирога она будет претендовать — по оценкам аналитиков, в настоящее время у NVIDIA более 90 % рынка. Обе компании взяли на себя обязательство выпускать новые ИИ-чипы ежегодно, а не раз в два года, что говорит о том, насколько жёстче стала конкуренция и насколько важны передовые ИИ-технологии для гиперскейлеров. AMD сообщила, что её чипы Instinct используются семью из десяти крупнейших игроков ИИ-рынка, включая OpenAI, Tesla, xAI и Cohere. По словам AMD, Oracle планирует предложить своим клиентам кластеры с более чем 131 тыс. ускорителей MI355X. Meta✴ сообщила, что уже использует AMD-кластеры для инференса Llama и что она планирует купить серверы с чипами AMD следующего поколения. В свою очередь, представитель Microsoft сказал, что компания использует чипы AMD для обслуживания ИИ-функций чат-бота Copilot.

18.04.2025 [12:18], Сергей Карасёв

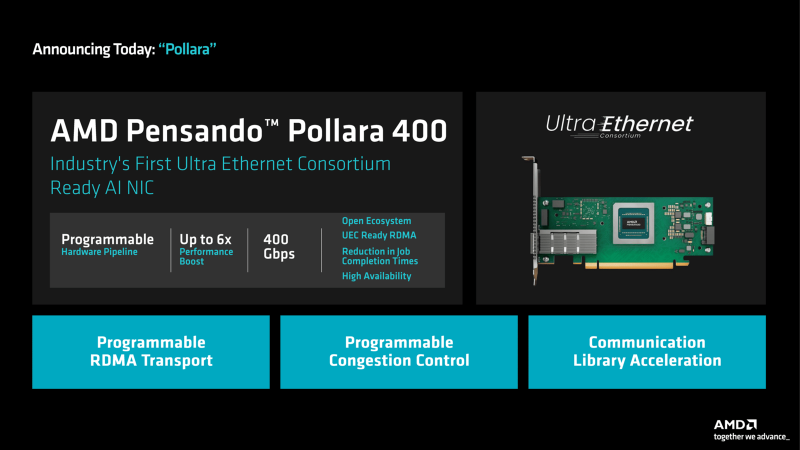

AMD выпустила DPU Pensando Pollara 400 для ИИ-инфраструктур с поддержкой Ultra EthernetКомпания AMD объявила о доступности DPU Pensando Pollara 400 AI NIC, первая информация о котором появилась в октябре прошлого года. Решение предназначено для построения высокопроизводительной ЦОД-инфраструктуры, ориентированной на рабочие нагрузки ИИ и машинного обучения. По заявлениям AMD, Pensando Pollara 400 — это первая в отрасли полностью программируемая сетевая карта AI NIC, разработанная с учетом стандартов консорциума Ultra Ethernet (UEC). Это обеспечивает максимальную гибкость, включая возможность добавления дополнительных функций. Новинка выполнена в виде низкопрофильной карты расширения половинной длины (HHHL) с интерфейсом PCIe 5.0 x16. Предусмотрен один порт QSFP112 400GbE с возможностью использования в режимах 25/50/100/200GbE. Заявлена поддержка RoCEv2, UEC RDMA, MCTP/SMBus, SPDM over MCTP, MCTP over PCIe VDM, а также шифрования AES-GCM 128/256. Реализованы различные функции, отвечающие за повышение быстродействия и эффективности. В частности, выборочная повторная передача помогает поднять производительность сети благодаря переотправке только потерянных или повреждённых пакетов. Контроль перегрузки с учётом пути даёт возможность оптимизировать производительность с помощью интеллектуальной балансировки нагрузки и автоматического обхода перегруженных маршрутов. Упомянуты также средства быстрого обнаружения неисправностей, инструменты обработки неупорядоченных пакетов и упорядоченной доставки сообщений. В целом, как подчёркивает AMD, благодаря совместимости с открытой экосистемой Pensando Pollara 400 помогает сократить капитальные затраты, не жертвуя при этом производительностью. Заказчики получают богатый набор функций и возможность программирования.

12.02.2025 [16:44], Сергей Карасёв

Cisco представила умные коммутаторы N9300 на базе DPU AMD Pensando и ASIC Silicon One E100Компания Cisco анонсировала интеллектуальные коммутаторы семейства N9300 Series Smart Switches, которые, как утверждаются, позволяют переосмыслить подход к обеспечению безопасности в ИИ ЦОД путём интеграции средств защиты непосредственно в сетевую структуру. В серию N9300 вошли модели Cisco 9324C-SE1U и Cisco 9348Y2C6D-SE1U типоразмера 1U. Они оснащены неназванным процессором Intel с 16 вычислительными ядрами, 96 Гбайт системной памяти и SSD вместимостью 480 Гбайт. Есть порт USB 3.0, а также порты управления RJ-45 и SFP (1 × 1GbE SFP у первой из названных версий и 2 × 10GbE SFP+ у второй). Коммутаторы несут на борту ASIC Cisco Silicon One E100, которая отвечает за сетевые функции. Кроме того, имеются сетевые сопроцессоры (DPU) AMD Pensando второго поколения: четыре чипа Elba у модели Cisco 9324C-SE1U и два чипа Giglio у модификации Cisco 9348Y2C6D-SE1U. Эти DPU отвечают за такие задачи, как распределение данных, балансировка нагрузки, обеспечение безопасности, шифрование и пр. По заявлениям Cisco, трафик интеллектуально перенаправляется между ASIC и DPU для достижения оптимальной производительности. Такой подход обеспечивает экономию средств благодаря консолидации оборудования, снижению энергопотребления и упрощению сетевой инфраструктуры. Клиенты получают возможность масштабировать сервисы и быстро адаптироваться к меняющимся бизнес-потребностям без необходимости в каких-либо дополнительных аппаратных решениях. В составе коммутаторов DPU обеспечивают сервисную пропускную способность до 800 Гбит/с. Устройство Cisco 9324C-SE1U оснащено 24 портами 100G, а ToR-вариант Cisco 9348Y2C6D-SE1U — 48 портами 25G, двумя портами 100G и шестью портами 400G. За охлаждение отвечают шесть вентиляторов, а питание обеспечивает блок мощностью 1400 Вт. Диапазон рабочих температур — от 0 до +40 °C. На устройствах применяется программная платформа Cisco NX-OS. Задействована фирменная система безопасности Cisco Hypershield на основе ИИ. По заявлениям разработчика, Hypershield интегрируется в коммутационный уровень, позволяя операторам дата-центров создавать защитный «микропериметр» вокруг каждой службы. Продажи младшей модели коммутатора начнутся предстоящей весной, старшей — летом.

11.10.2024 [11:55], Сергей Карасёв

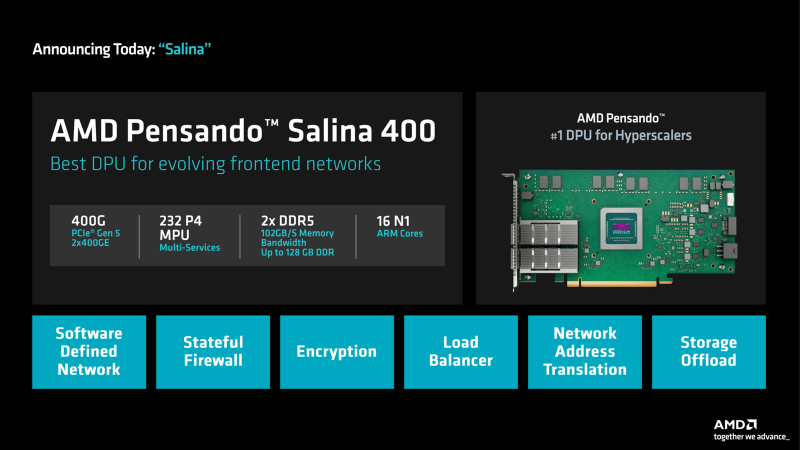

DPU + UEC: AMD представила 400G-адаптеры Pensando Salina и PollaraКомпания AMD анонсировала сетевой сопроцессор (DPU) третьего поколения Pensando Salina 400, а также сетевую карту Pensando Pollara 400, ориентированную на применение в составе ИИ-систем. Образцы изделий станут доступны заказчикам в текущем квартале, тогда как массовые продажи начнутся в I половине 2025 года. Решение Pensando Salina 400, рассчитанное на сетевые кластеры гиперскейлеров, обеспечивает пропускную способность до 400 Гбит/с. Утверждается, что по сравнению с DPU предыдущего поколения производительность увеличилась в два раза. Устройство Pensando Salina 400 выполнено в виде карты PCIe 5.0 с двумя портами 400GbE. Задействованы 16 ядер Arm Neoverse-N1 и 232 ядра P4 MPU. Объём памяти DDR5 достигает 128 Гбайт, её пропускная способность — 102 Гбайт/с. Новинка будет применяться в том числе в интеллектуальных коммутаторах, предназначенных для решения различных задач во внешней зоне: это может быть распределение данных, балансировка нагрузки, обеспечение безопасности, шифрование и пр. В свою очередь, Pensando Pollara 400 представляет собой интеллектуальный сетевой адаптер с одним портом 400 Гбит/с. Изделие выполнено на том же чипе, что и Pensando Salina 400. Компания AMD называет Pensando Pollara 400 первой в мире сетевой картой для приложений ИИ, соответствующей стандартам, которые определяет консорциум Ultra Ethernet (UEC). Примечательно, что первые спецификации консорциум намерен представить не раньше конца текущего года. Цель UEC — разработка основанной на Ethernet открытой высокопроизводительной архитектуры с полным коммуникационным стеком, отвечающей задачам современных рабочих нагрузок ИИ и НРС. Благодаря программируемой архитектуре P4 адаптер можно настраивать с учётом конкретных требований. В целом, как утверждается, новинка является мощным решением для повышения производительности рабочих нагрузок ИИ и улучшения надёжности сети.

|

|